Sommaire : Trois questions à Marc Shapiro| L'actualité de la semaine | Entreprises | La recherche en pratique | Manifestations | Le livre de la semaine | Détente

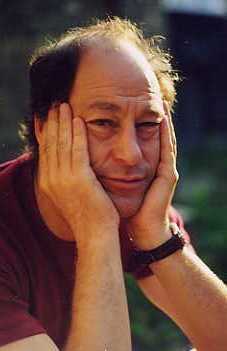

Asti-Hebdo : Vous projet actuel est baptisé Icecube. Un glaçon pour ramener le calme dans les systèmes distribués?

Marc Shapiro : L'objectif du projet est de réconcilier des systèmes qui ont divergé. En effet, les utilisateurs qui partagent des fichiers et des documents font des copies sur leurs machines, que nous appelons des réplicats (anglais replicas). Il peut s'agir de travail collaboratif, ou d'une même personne qui emploie plusieurs machines, pour des applications comme l'agenda, par exemple. Le projet vise des machines d'une certaine puissance, mais pourquoi pas des portatifs, voire des machines de poche... il n'y a pas de limitation a priori.

Les réplicats ayant divergé, il faut les réconcilier. La technique la plus courante consiste à comparer les états divergents . Mais on a perdu l'information sur ce qui les a engendrés. Dans notre projet, au contraire, on enregistre les actions qui ont conduit à l'étape actuelle. Le système détecte la plupart des conflits statiquement, par comparaison des actions entre elles. Toute paire d'action qui violerait un "invariant" (une règle de validité des données) constitue un conflit. Par exemple deux demandes de rendez-vous au même moment sont conflictuelles. Le système prend aussi en compte les dépendances entre actions. Il les rejoue en tenant compte de ces informations. Si pendant l'exécution d'autres conflits apparaissent (par exemple un compte bancaire qui devient débiteur), il propose une exécution différente.

Il ne faut pas qu'il y ait trop de conflits, car les divergences croissent exponentiellement. Plus exactement, il y a toujours une solution minimale : choisir l'une des réplicats aux dépens des autres. Mais nous cherchons à trouver une solution optimale. Pour la calculer, on attribue des valeurs à chaque action, de là à chaque combinaison d'actions, et l'on arrive à une valorisation de chaque alternative.

Actuellement, la maquette fonctionne dans un environnement .net, et peut s'interfacer avec quelques applications dans ce cadre. Ce n'est pas tellement cette base technique qui fait l'intérêt du projet, mais l'idée de rechercher un optimum dans ce type d'espace, et la manière de représenter cet espace. Nous appelons "contraintes" la manière dont nous représentons les invariants. Ce sont des structures simples, qui permettent cependant de représenter des systématiques compliquées.

Pour faire fonctionner une application sous notre système, il faut que celle-ci déclare ses contraintes relatives à chaque alternative. Il peut s'agir de contraintes d'ordre (telle action ne peut s'exécuter avant telle autre), d'inférence (si vous exécutez telle action, il faut ensuite exécuter telle autre action), de contradiction (si vous exécutez telle opération, il ne faut pas exécuter telle autre...). L'ensemble s'exprime sous forme d'un graphe, qu'on décrit en Java ou C#. Nous le gérons dynamiquement Au fur et à mesure de son exécution, le moteur demande aux applications ce qu'elles font et les contraintes associées. L'application de base est la gestion des fichiers et des répertoires.

A.H. : Vous avez travaillé dans le cadre de grands organismes français, vous êtes maintenant dans une grande entreprise américaine. Les conditions de la recherche sont-elles très différentes ?

M.S. : Il est paradoxal de voir que les chercheurs français sont mieux considérés aux Etats-Unis qu'en France. Aux Etats-Unis, un docteur en informatique trouve facilement du travail. En France, il bute sur un problème de reconnaissance. La thèse n'est pas considérée comme un vrai diplôme, pas valorisée comme un titre d'ingénieur.

Ce qui est grave, c'est que les chercheurs français en informatique ont beaucoup de mal à s'imposer sur la scène internationale. Une des raisons de fond, c'est que nos thésards n'ont pas le temps nécessaire pour approfondir. Aux Etats-Unis, dès la licence, l'étudiant intéressé par la recherche est introduit dans un laboratoire, y fait des stages. Ensuite, il a au moins cinq ans pour faire sa thèse, ce qui lui permet de développer ses idées, d'expérimenter et même de changer de sujet s'il voit qu'il a fait fausse route. Il a le temps de soigner ses publications, de les mûrir.

En France, il faut tout faire en trois ans, parce qu'ensuite il n'y a plus de financement. Le doctorant est dirigé, trop vite, sur un créneau trop étroit. Il est obligé de bâcler ses publications, qui sont donc difficilement acceptées dans les revues de niveau international. Les universitaires, notamment en informatique, sont accablés par les tâches d'enseignement. Il est bon qu'un chercheur, même débutant, enseigne (et je trouve excellent que l'Inria coopère avec les universités), mais à condition qu'il lui reste beaucoup de temps pour sa recherche.

Chez Microsoft, l'organisation de la recherche cumule les avantages du milieu universitaire et du milieu commercial. Les chercheurs définissent eux-mêmes non seulement leurs objectifs de recherche mais aussi leur calendrier. Il n'ont aucune garantie d'emploi à vie, mais ils sont autonomes. Une fois par mois, je rencontre mon responsable. Tous les six mois, un rapport de deux pages et une réunion plus importante permettent de faire un point approfondi.

Une équipe d'une dizaine de personnes (dont une à Cambridge), les "Program managers" a pour mission exclusive de faire le lien entre les groupes produit et les groupes recherche. Régulièrement, ils viennent voir où nous en sommes. Nous leur parlons de nos projets, de projets possibles qui nous paraîtraient intéressants. Et ils vont voir les groupes produits pour voir les problèmes qu'ils rencontrent et les solutions qu'ils pourraient trouver chez nous.

Enfin, une fois par an, la Techfest donne l'occasion aux chercheurs de présenter ce qu'ils font, pendant deux jours, aux équipes "produit". La dernière s'est passée en février dernier à Redmond (le siège social). 7000 ingénieurs et responsables produits sont venus, dont quelque 200 sont passés sur mon stand.

Même aux Etats-Unis, je crois qu'IBM est la seule entreprise en dehors de la nôtre qui organise ce type de relations. Les autres ont des laboratoires, bien sûr, mais la recherche y est beaucoup plus pilotée par l'aval, par les produits. Les chercheurs n'y ont pas l'indépendance nécessaire pour déboucher sur des résultats à long terme. Il est bon que les chercheurs soient au contact des commerciaux, mais pas qu'ils leur soient subordonnés.

Ce type de structure n'existe pas en Europe. Ce qui y ressemblerait le plus, c'est l'Inria, avec ses équipes indépendantes, les "projets", dotées de leurs propres budgets. Mais, et cela a été ma grande frustration, il n'y a pas de relations organisée avec les débouchés de la recherche. A moins de monter sa propre entreprise.

A.H. : Comment se présentent les débouchés de votre projet, qui semble bien abstrait dans son principe ?

M.S. : Nos approches vont prendre de l'importance avec la montée des systèmes répartis, du pair-à-pair. Si l'on veut que le système reste cohérent, il faut pouvoir résoudre les conflits. Ce qui suppose d'ailleurs, un minimum de centralisation. Il ne faut pas empêcher les utilisateurs de créer des conflits, car cela gênerait leur progression. Mais il faut aussi rétablir la cohérence. Nos travaux cherchent une sorte de compromis idéal. Je ne pense pas qu'ils soient particulièrement novateurs dans leurs objectifs. Mais j'y ai apporté un regard différent, une formalisation que je trouve meilleure que les précédentes.

Concrètement, pour que notre maquette débouche sur le plan des produits commerciaux, il faudra que les logiciels d'application eux-mêmes disposent d'une interface appropriée pour décrire leurs contraintes. La réconciliation est basée sur la sémantique. Il faut que les applications puissent dire au système : voilà les actions qui sont en conflit, voilà ce qu'on peut faire pour les résoudre, voilà la valeur des différentes actions.

Mais le langage de déclaration des contraintes est universel, et un tel système peut donc faire de la réconciliation entre plusieurs applications. La démonstration que nous avons faite à la dernière Techfest comportait une maquette d'agenda partagé, de gestion de compte bancaire et de réservation de places d'avion. Il s'agissait d'organiser un voyage pour que deux personnes se rencontrent, en vérifiant que les deux personnes étaient disponibles, qu'elles pouvaient trouver une place d'avion, et que leurs fonds étaient suffisants pour payer le déplacement. On proposait une date, et le moteur montrait la solution la plus intéressante résolvant les différents conflits, en expliquant les raisons de ses choix.

Les contacts que nous avons eu à la Techfest nous conduisent à viser un produit de gestion pour très petites entreprises, par exemple un cabinet de médecins ou une petite clinique, avec des infirmières, des radiologues, des techniciens, des salles et des équipements qu'il faut réserver.

Propos recueillis par Pierre Berger

Les déclarations ont encore été nombreuses cette semaine.

Claudie Haigneré, ministre déléguée à la Recherche et aux nouvelles technologies, a annoncé qu'aucune nouvelle annulation de crédits ne touchera les établissements publics de recherche (EPST) en 2003 et que les "gels" constitués voici quelques semaines sur leurs budgets sont entièrement levés. De ce fait, les établissements disposeront effectivement de la totalité des crédits ouverts en loi de finances initiale 2003 hors la part d'annulation déjà réalisée de moins de 10%, sur les moyens des organismes (hors rémunérations). Lire le communiqué du ministère.

Le communiqué indique en particulier qu'une enquête portant

sur l'impact de la loi de finances 2003 va être prochainement menée

au CNRS et à l'Institut national de la santé et de la recherche

médicale (Inserm). Cette étude mise en place à la demande

du ministère de la Jeunesse, de l'Éducation nationale et de la

Recherche et du ministère de l'Économie des finances et de l'industrie

a pour objectif : "d'identifier avec précision et sur un échantillon

représentatif, l'impact sur les laboratoires des décisions globales

prises sur les crédits des organismes..." Une fois cet état

des lieux dressé, des "mesures correctives" pourront être

éventuellement mises en place. Cette enquête sera réalisée

par l'Inspection générale de l'Administration de l'Éducation

nationale et de la Recherche et par l'Inspection générale des

Finances.

" - En 2003 aucune nouvelle annulation de crédits de paiement et d'autorisation de programme : Dont acte, mais cela ne change rien sur ce qui a été supprimé.

"- Les réserves de précaution sur les AP (soit 160 M¤) sont levées : OK le Gel est dégelé. Mais rien ne nous dit que dans 3 ou 6 mois le gel ne soit pas annoncé à nouveau. Ce matin le Ministre des Finances a demandé que de nouveaux gels soient anticipés dans toutes les administrations. Donc qui croire ??

"- Hors la part d'annulation inférieure à 10 % déjà réalisée, les crédits ouverts en loi de finance initiale 2003 seront intégralement versés : Ok, les annulations faites restent. Je rappelle qu'elles ont été inégales pour les EPST, et que c'est le CNRS qui a été l'un des EPST le plus touché en pourcentage (38 Millions d'euros).

"- En mobilisant les reports de crédits non consommés en 2002, et ceux qui restent à verser, les organismes disposeront ainsi en 2003, de CP au moins égaux à ceux qui ont été réellement consommés en 2002 : Je rappelle, que ce n'est pas un report de crédits non consommés en 2002, mais une suppression de cette part non consommée sur le budget 2003, soit 30 Millions d'euros pour le CNRS. En fait elle nous dit, vous aurez à dépenser le budget 2002 moins ce que vous n'aviez pas dépensé sur ce budget. Ceci est de la poudre aux yeux ! En effet, la situation actuelle des crédits dans les labos est provoquée par la suppression de la part non consommée en 2002 et par l'annulation de crédits sur le budget 2003. Le gel précipitait encore le problème. Mais la situation n'a pas changé pour cela.

"Donc en fait nous sommes toujours dans la même situation. S'il n'y a plus de gel, et s'il n'y a pas de nouvelles annulations de crédits (mais rien n'est sûr), aucune assurance qu'à l'automne 2003 on ne nous refasse pas le coup de l'automne 2002, à savoir, ce que vous n'avez pas dépensé à la fin 2003 sera annulé sur 2004 !Enfin dans ce discours, rien sur l'emploi scientifique ! Tout ceci ne répond pas à l'inquiétude que l'on peut avoir sur l'avenir de la recherche scientifique."

Philippe Crouzillacq , 0.1. Net, indique que Claudie Haigneré et Nicole Fontaine lèvent le voile sur le « plan innovation » du gouvernement. Les ministres déléguées à la Recherche et à l'Industrie ont détaillé, devant un parterre d'experts réunis à la Maison de la Chimie à Paris, les grands axes de la politique que le gouvernement Raffarin entend mener en faveur de l'innovation. Pour lire l'article complet : http://www.01net.com/article/205806.html

François Jacob, prix Nobel de médecine : "Jusqu'où ira le déclin ? "Deux signes infaillibles : diminution du nombre des brevets, accroissement du nombre de jeunes chercheurs parmi les plus brillants qui s'exilent". (Le Monde du 8 avril).

Henri Audier, directeur de recherche, membre du CA du CNRS : "Il est temps d'en finir avec ce suicide national. Sinon, la situation actuelle ne sera qu'un avant-goût de la domination américaine sur le monde". (Le Monde du 8 avril).

François Jeanne, rédacteur en chef du Monde informatique : "Il y a toujours eu débat autour de l'indépendance nécessaire des chercheurs, qui souhaitent travailler à long terme, et donc ne pas fréquenter un milieu des entreprises soupçonné, avec raison parfois, de ne raisonner que pour le prochain trimestre fiscal. Mais à force de chercher sur des projets trop peu concrets immédiatement pour leur industrie, les chercheurs informatiques ont fini par trouver... une indifférence à peine polie. Et se retrouvent aujourd'hui à chercher... des sous". (Le Monde informatique, 11 avril).

"Les innovations fulgurantes des NTIC acquises ces dix dernières années permettent de concevoir des applications et des systèmes d’information répondant beaucoup mieux aux besoins de convivialité réclamés par tous les usagers de l’informatique qui depuis longtemps ne sont plus majoritairement les informaticiens. Le dilemme pour les maîtres d’ouvrages et les directions informatiques est simple dans sa formulation, mais à haut risque: refaire ou adapter le parc des applications pour exploiter ou introduire le potentiel d’évolution des NTIC. C’est une façon de conserver, ou de gagner, un avantage compétitif cher à Michael Porter grâce à ces nouvelles facilités technologiques.

"Dans le premier cas il faut mettre sur pied des projets complexes de très grande taille dont les budgets se chiffrent en centaines d’hommes.années de réalisation et donc accepter un risque d’échec considérable: on a encore en mémoire les démêlés étalés dans la presse entre EDF et ses sous-traitants à propos d’Optimia, ainsi que les résultats de l’étude Chaos du Standish group.

"Dans le second cas, il faut procéder à une chirurgie de grande précision de façon à isoler dans les applications, ce qui est dépendant d’une plate-forme “main-frame” pour le remplacer par une architecture client-serveur, ou identifier la fonction métier que l’on pourra aller chercher comme un service dans un PGI, voire comme un service disponible en libre sur le réseau. Il faut pour cela une vision très claire de l’entreprise et de sa chaîne de valeur, là encore chère à Michael. Porter.

"Dans les deux cas il faut définir, ou reconstruire, une architecture qui va fonctionner comme une infrastructure d’intégration, un “framework”, qui va être le garant de la pérennité des investissements sur le long terme. Il est donc essentiel de standardiser la description de l’architecture, et ceci à un niveau beaucoup plus générique, adaptabilité oblige, que ce qui avait été fait à travers des technologies comme IDL et Corba, au demeurant peu utilisées. C’est l’objectif avéré des approches MDA (Model-driven architecture), MOF (Meta object facility), et autres… en cours de définition à l’OMG. Dans le cas d’une rétro-conception, la question fondamentale qui se pose est celle de l’équivalence sémantique entre le modèle rétro-conçu en vue de la migration /adaptation et de l’application “legacy” initiale. Nous savons tous que ce type d’équivalence est ce qu’il y a de plus difficile à garantir à 100% sans faire diverger l’application “portée” de l’application initiale.

Ces journées ont pour but d’analyser les promesses et les risques des technologies MDA promues par l’OMG et de ce qu’en ont fait des industriels comme Sodifrance, ici contributeur, dans le montage de projets de migration de grande ampleur. Une première journée (11 juin) sera consacrée à des exposés didactiques pour que chacun des participants puisse s’approprier la problématique. Une seconde journée (12 juin) sera consacrée à des retours d’expérience et à un premier bilan lucide des possibilités de ces nouvelles approches pour résoudre des problèmes bien concrets de migration des parcs d’applications.

Au programme :

La problématique de la migration: le rôle de l’architecture, par Jacques Printz, titulaire de la chaire de Génie logiciel du Cnam. Cette introduction l’animateur servira à analyser le rôle de l’architecture dans le pilotage d’un projet de migration. La migration d’une application vers une nouvelle cible est considérée comme terminée lorsque les résultats de l’application dans son nouvel environnement sont strictement équivalents à ce qu’ils étaient dans l’environnement de départ. Il est donc fondamental de décrire les comportements de l’application et les caractéristiques relatives à la qualité que l’on veut voir être préservés sur la cible, de façon à se donner le moyen de valider la transformation correspondante. L’architecture est ce qui va permettre de structurer le projet de migration.

L'ingénierie des modèles logiciels et l'approche MDA de l'OMG, par Jean Bézivin, équipe Atlas, Inria et Irin, université de Nantes et Pierre-Alain Muller université de Haute Alsace, Mulhouse. L'introduction dans les années 1980 de la technologie des objets a permis le remplacement du paradigme de décomposition fonctionnelle par celui plus souple de la composition d'objets. Étonnamment, cette évolution semble déclencher aujourd’hui un changement bien plus radical: le passage de la programmation directe à la transformation de modèles. Signe concret de cette évolution, l’OMG (Object management group) est en cours de transition rapide entre sa vision précédente OMA (Object management architecture) et celle du MDA (Model-driven architecture).

L’approche MDA se démarque des démarches traditionnelles de développement, centrées sur la production directe de code, pour explorer de nouvelles techniques de production d’applications informatiques, basées sur la distinction entre modèles indépendants des plates-formes (PIMs, Platform independent models) et modèles de conception et d’implémentation spécifiques (PSMs, Platform specific models). L'apparition rapide de nouvelles plates-formes et le besoin de garantir les investissements informatiques contre l'obsolescence technologique ont servi de déclencheur à cet important changement de paradigme. Le phénomène de transition technologique est pris en compte dans son aspect routinier et ordinaire et non plus dans son aspect exceptionnel. Les transitions technologiques du passé (legacy) vers le présent peuvent se traiter de la même façon que les transitions technologiques du présent vers le futur: séparation des aspects par des modèles basés sur des méta-modèles explicites, expression également explicite des opérations de transformation et de composition de ces aspects afin d'obtenir des systèmes exécutables, etc.

Ce nouveau décalage pose de nombreuses questions, auxquelles le tutorial s’efforcera d’apporter des éléments de réponses. Quelle est la part de marketing et de réalité concrète derrière le MDA? Quelles sont les chances de succès de déploiement de cette technologie? Y’a-t-il de nouveaux concepts dans la proposition OMG ? Quelles sont les notions théoriques qui pourraient être utiles pour le déploiement réussi de MDA? Quels seront les changements prévisibles dans le processus industriel de développement et de maintenance du logiciel avec MDA?

Conduite d’un projet de migration, par Laurent Blondon (Sodifrance). La migration d'un système d'information vers un nouvel environnement technologique est une alternative séduisante à une refonte: capitalisation et valorisation du patrimoine applicatif existant, réduction majeure des risques, des coûts et des délais. Un changement de plate-forme, passage de GCOS à MVS ou à Unix par exemple, se prête parfaitement à une migration et à une approche industrielle et outillée. De nombreuses expériences concrètes en la matière attestent de la maturité de cette approche. Dans le cadre d’un changement d’architecture, comme le portage d’applications client-serveur NSDK vers une architecture n-tiers J2EE, une automatisation se heurte à davantage de complexités. Une “simple” traduction de code ne permet pas, en effet, de tirer parti du changement d’architecture et de technologie.

L’animateur décrira en détail la démarche consistant à abstraire la problématique en “remontant” au niveau des modèles. Une telle démarche de “migration par le MDA” suppose une capacité de rétro-modélisation des applications existantes pour créer des modèles de conception UML, qui pourront ensuite servir de cadre à une génération de code vers la cible retenue. Une politique soutenue de R&D sur les techniques de reverse-engineering, de slicing de code et de méta-modélisation permet aujourd’hui d’obtenir des résultats probants et de mener des projets complexes de migration.

La journée du 12 juin sera entièrement consacrée à des exposés présentés par des praticiens du terrain qui feront part de leur expérience en matière de migration d’applications dans le contexte de systèmes d’information d’entreprise.

Renseignements & Inscriptions: Jean-Claude Rault. Voir : Le site web du CMSL

Le mél du web SG (CNRS) rappelle que l'appel à candidatures pour

le prix "Information Society Technologies" (IST), la distinction européenne

la plus prestigieuse pour les produits ou services innovants dans le domaine

des technologies de la société de l'information, est lancé

dans 33 pays. Il est ouvert à toute entreprise, organisation et laboratoire

qui crée des produits ou des services innovants ayant un fort potentiel

de développement. La date limite de dépôt de dossier est

le 15 mai 2003.

Pour en savoir plus : http://www.ist-prize.org

Pour postuler : http://www.ist-prize.org/apply/apply.html

La seconde édition du SOC 2003 (Symposium international sur les objets

communicants ou Smart objet conference) se tient du 15 au 17 mai prochain à

Grenoble. Co-organisé par le CNRS et France Télécom R&D,

elle réunit les experts et les chercheurs en provenance notamment du

Massachusetts institute of technology (MIT) de Berkeley et du CNRS. Ils exploreront

ensemble "les voies et infrastructures communicantes qui influenceront

demain notre vie quotidienne".

le

communiqué sur le site du CNRS . Le

programme, les inscriptions, les intervenants :

- Afia

- Afig

- Afihm

- ASF - ACM Sigops

- Atala

- Atief

- Cigref

- Creis

- GRCE

- Gutenberg

- Inforsid

- Specif

Il y a un an paraissait le "Services Web" de Jean-Marie Chauvet, chez Eyrolles. Cette année, Dunod relève le gant avec "Les web services", d'Hubert Kadima et Valérie Monfort. Cette fois encore, l'ouvrage passe en revue les technologies disponibles, dans une optique essentiellement pratique.

Au sommaire : XML (modèles de données, manipulation des structures de données, transformation des structures de données), Soap, UDDI, WSDL... puis les outils : plate-formes, programmation Java, processus de développement, implémentation, avec des chapitres sur la collaboration entre processus métier et les modèles sectoriels.

Les deux ouvrages sont pour une part complémentaire, le dernier étant plus proche des applications et des métiers, le premier allant plus en détail dans le socle technique.

"Boire ou conduire il faut choisir. J'ai pas le permis, j'ai pas le choix". (Anonyme)

Lisez d'abord : http://www.cnn.com@cgrom.com/news/law/gatesmurder/index.shtml

Puis : http://times.hankooki.com/lpage/200304/kt2003040418034312070.htm