Automate logique calculant, l'ordinateur interpelle la science

Colette Hoffsaes

"Histoire et épistémologie de l'informatique"

Groupe Afcet, AILF, Creis

Comité technique "Cultures, techniques et organisation"

IUT Paris V, département informatique

143 avenue de Versailles, 75016 Paris

Cette intervention présente une synthèse des travaux du groupe

"Histoire et épistémologie de l'informatique" depuis

quelques années. La réflexion épistémologique sur

l'informatique poursuit les débats à propos de l'automatisme,

de la logique et du calcul, les trois traditions au carrefour desquelles l'ordinateur

s'est développé. Automate, l'ordinateur tend à l'homme

un miroir dans lequel il découvre ses démarches cognitives ; outil

logique, il radicalise l'exigence de rationalisation du langage et du raisonnement

; machine à calculer, il met au service des sociétés humaines

une puissance de traitement qui modifie profondément les activités

d'organisation et de communication. La convergence de ces problématiques

renouvelle leur approche et remet en question des fondements de la science moderne.

Mots-clés : informatique, épistémologie, rationalisation

This paper resumes the works of the "History and epistemology of data

processing" work group over the last few years. Espistomologic thinking

on data processing continues being debated on automatism, logic and computation,

the three traditions in which intersection has helped the computer develop.

As an automat, the computer holds out to man a mirror which reflects his cognitive

steps ; as a logical tool, it strenghtens the requirements or rationalization

of language and reasoning ; as a computing machine, it offers to human species

a power of processing which deeply modifies the activities of organization and

communication. The convergence of these issues renews the approach to them and

questions the bases of modern science.

Keywords : data processing, epistemology, rationalisation.

L'informatique n'a pas surgi par hasard d'un cerveau original : c'est un produit

de la société industriel. Elle a hérité de trois

traditions techniques : l'automatique, la logique et le calcul.

Automate, l'ordinateur fut conçu par l'homme pour s'imiter

lui-même : une sorte de miroir dans lequel il puisse s'observer ; c'est

bien là que réside la magie des automates. L'originalité

de l'ordinateur est de s'appliquer aux activités intellectuelles qu'on

croyait jusqu'alors l'apanage des êtres humains. La recherche sur la cognition

en est renouvelée.

Logique est l'ordinateur en cela qu'il hérite des travaux

des logiciens du 19ème siècle, ceux qui ont poussé le plus

loin l'ambition de créer une méthode de raisonnement et un langage

parfaits qui échappent aux ambiguïtés des subjectivités

et aux incertitudes des contextes.

Calculant vite et sans erreur, l'ordinateur n'est pas une

machine abstraite, mais opérationnelle. Il sert à réaliser

de des travaux qu'on peut transcrire en formules rationnelles. Pour profiter

de cet atout réputé pour puissance, les hommes ont appris à

transformer en calculs de nombreuses activités qui n'en relevaient pas.

La convergence en l'informatique de ces trois traditions ravive les questions

épistémologiques. C'est le thème de réflexion privilégié

de notre groupe de travail "Histoire et épistémologie de

l'informatique" depuis quelques années. La synthèse que j'en

propose ici se veut fidèle mais ne peut être que très personnelle,

reprenant des apports de conférenciers invités, mais aussi la

teneur de nos discussions.

Automate, l'ordinateur est un miroir pour l'homme

De tout temps, l'homme a cherché à fabriquer des êtres

ou des machines qui lui ressemblent, la machine étant définie

comme un être artificiel, dont le mouvement et les finalités dont

donnés de l'extérieur, par opposition aux êtres vivants,

capables de se mouvoir et de se régir eux-mêmes (1).

Les automates, ou machines qui se meuvent elles-mêmes, ont fasciné

l'homme, non pas tant parce qu'ils pouvaient le soulager de travaux pénibles

(cette idée est relativement récente), mais parce que l'homme

pouvait s'y reconnaître, soit en les regardant fonctionner, soit surtout

en les fabriquant. La question fondamentale a toujours été de

savoir si l'homme était capable de créer des êtres intelligents,

et autonomes comme lui, et si ceux-ci ne risquaient pas, un jour, de lui échapper.

Un avatar moderne de cette recherche se nomme cybernétique (2), mouvement

savant né des recherches de la guerre et regroupant des spécialistes

de disciplines différentes pour la mise au point de servomécanismes.

Les cybernéticiens se sont efforcés de concevoir des machines

qui se "gouvernent" elles-mêmes, et, en en interprétant

les êtres vivants comme des machines complexes auto-régulées

(3), se sont servis de leurs automates pour tenter de comprendre hommes et sociétés.

De nombreux savants qui se sont illustrés par la suite par leurs activités

novatrices ont été mêlés de près ou de loin

aux conférences fondatrices de la cybernétique. Bien que celle-ci

soit tombée en disgrâce depuis quelques années, nous lui

devons un ensemble d'idées nouvelles et de concepts, notamment la notion

de régulation, l'accent sur l'importance de l'information (l'idée

d'une société de l'information en découle), le développement

ultérieur du concept de système, etc.

Le fondateurs de l'informatique (Turing, von Neumann...) ont eu des contacts

avec la cybernétique, mais ils s'en sont séparés par leur

intérêt pour les machines digitales (alors que les cybernéticiens

étaient orientés vers les machines analogiques) (4), et par des

visées plus opérationnelles tandis que les cybernéticiens

se laissaient entraîner à de vastes réflexions, élucubrations

disent certains, à propos de l'homme, de la société, de

la culture, etc.

Le domaine des recherches qu'il est convenu d'appeler "intelligence artificielle"

ou IA poursuit en partie les buts de la cybernétique, en s'efforçant

d'imiter ou de simuler (5) les comportements intelligents humains. Cependant,

on y retrouve deux orientations antagonistes : une recherche fondamentale, visant

à mieux comprendre l'homme en tentant de simuler ses comportemental,

une recherche appliquée aux ambitions plus prosaïques visant l'efficacité

(les systèmes experts notamment).

On peut donc parler de l'informatique comme "science de la connaissance",

non parce qu'elle permet d'emmagasiner et de diffuser (toutes) les connaissances

(comme on le dit parfois), mais parce que, pour simuler les activités

intellectuelles humaines, elle est amenée à les mieux connaître

; d'où le développement des "sciences cognitives" don

Daniel Andler (6) nous a exposé les promesses. D'ailleurs, avec l'informatique,

les méthodes de simulation progressent dans la recherche scientifique

: de plus en plus, pour comprendre un phénomène, on cherche à

le reproduire.

La tendance à imiter le cerveau s'actualise notamment dans le domaine

des "automates neuronaux", qui s'inscrit dans la lignée des

recherches des biologiques Mc Culloch et Pitts, qui furent associés aux

travaux des cybernéticiens. Un automate neuronal est un circuit caractérisé

par les liaisons entre ses éléments, plus ou moins compliquées

(à sens unique ou réversibles, avec seuil ou non...). Un tel circuit,

défini a priori, est susceptible d'établir, après quelques

temps de fonctionnement, une configuration relativement stable qu'on peut, avec

un peu d'imagination, assimiler à un apprentissage. Ces automates savent

résoudre certaines problèmes spécifiques comme la reconnaissance

des formes ou le traitement d'objets polysémiques, mais ils se heurtent

au mur de la combinatoire et buttent encore sur les questions d'interface, selon

Gérard Verroust (7).

L'ensemble de ces recherches a fait évoluer les modèles scientifiques

: dépassant le modèle mécanique univoque, vers un modèle

régulé plus complexe, mieux adapté à la biologie

et centré sur la notion d'organisation. Enfin, la réflexion sur

l'autonomie (caractéristique du vivant) a fait émerger de nouveaux

concepts, tels que l'organisation par le bruit (8).

Par ailleurs les recherches en IA, notamment à propos de la compréhension

du langage naturel, ont dévoilé la richesse et la subtilité

de l'aptitude humaine toute ordinaire à parler. L'IA, affirme Jacques

Pitrat (9), pèche par hypothèse implicite qu'un programme sachant

résoudre des problèmes difficiles pour un homme, saura de facto

résoudre les problèmes apparemment triviaux. L'analyse du langage

en est un bon exemple car la compréhension s'appuie non seulement sur

la compétence linguistique mais aussi sur un apprentissage de l'interactivité

sociale acquise dès la prime enfance. Un des enjeux majeurs actuels des

sciences cognitives est l'accès aux connaissances : reconnaître

la part des structures cérébrales et de l'imprégnation

(des événements et des expériences) dans la formation de

l'intelligence humaine, et concevoir un modèle qui intègre ces

deux éléments, tout en expliquant les processus de l'invention,

cette faculté de bouleverser brusquement une organisation cognitive en

la confrontant à une donnée inattendue, hétérogène,

souvent originaire d'un autre niveau de pensée.

Ce qui est remarquable, c'est que plus on progresse dans la simulation et la

connaissance des activités de compréhension, plus celles-ci se

révèlent complexes et inaccessibles, comme le montre Alain Lecomte

(10) à propos de l'analyse de deux textes historiques portant sur le

même thème. Partant des mêmes données, ils aboutissent

à des conclusions contradictoires, malmenant apparemment la logique :

comment en rendre compte ?

Logique, l'ordinateur éprouve le raisonnement de l'homme

La logique a pour objet fondamental d'étudier les moyens de raisonner

en recherchant la justesse. Or nous ne pouvons pas raisonner sans langage et

l'expérience la plus commune manifeste à la fois l'immense pouvoir

de compréhension du langage et ses profondes ambiguïtés.

Voilà pourquoi on ne peut dissocier l'étude de la logique de celle

du langage.

Le langage sert à la fois à représenter le monde et à

communiquer. De ces deux opérations, aucune ne prévaut sur l'autre.

Fondées sur le langage, aptitude humaine à parler, les langues

naturelles sont élaborées de façon continue par des collectivités

vivantes. L'enfant découvre sa langue dite maternelle comme une technique

de vie qu'il observe et pratique en agissant avec son entourage. La langue est

donc transmise à chaque être humain au cours de son expérience,

mais par ailleurs elle est sans cesse modifiée et remodelée par

les actions sur le monde et les interactions d'une société parlante.

Lorsqu'une langue représente la "réalité", elle

n'en fait donc pas une copie neutre et objective ; elle l'interprète

en fonction des connaissances de l'histoire, des désirs et des projets

de la collectivité qui la parle. Il suffit de comparer plusieurs langues

pour s'en convaincre.

En effet, au delà de la simple désignation d'un objet unique

par un nom (propre), lorsqu'on "dénomme", c'est-à-dire

qu'on rassemble sous un même nom (commun) un certain nombre d'objets auxquels

on reconnaît une ou plusieurs caractéristiques communes, on se

libre à une activité classificatoire qui organise la réalité.

Notre "représentation du monde" est donc une sélection

culturelle. Nous n'avons pas d'accès direct au monde, nous l'appréhendons

toujours à travers notre culture et notre expérience, chaque culture

ou sous-culture se dotant d'une langue qui lui permet de répondre aux

questions qui se posent à elle.

Cette médiation sociale entre le monde et le langage entraîne

des fluctuations telles que tout message doit être interprété

: chacun sait que les langue ordinaires prêtent souvent à confusion,

parce qu'elles sont infiniment modulables, le problème venant essentiellement

de la "référence", c'est-à-dire de la relation

entre la réalité et sa représentation, entre le signifié

et le signifiant.

On a donc depuis longtemps cherché à élaborer une langue

non ambiguë, plus "objective", indépendante des circonstances

et universelle ; c'est le but de la logique. Dès le 4eme siècle

avant J-C, Aristote avait fondé la logique formelle sur le syllogisme.

au 19erme siècle, des logiciens choisissent la voie des mathématiques,

que connaît bien Bernard Jaulin (11). Tandis que Frege et Russell s'efforçaient

de créer une langue pure, débarrassée de tout faux problème

en isolant d'une part le traitement formel des signes et d'autre par les considérations

de sens, ou de référence au monde, repoussant à la fin

du traitement l question de savoir s'il existe un "x" qui vérifie

la fonction résultant du calcul. David Hilbert, le vrai fondateur des

mathématiques modernes, adoptait un point de vue "formaliste",

par lequel l'activité mathématique se ramène intégralement

à une manipulation réglée de symboles dans laquelle la

forme seule intervient, à l'exclusion du sens.

Pourtant, en 1931, Kurt Gödel (12), puis Church, montrèrent que

le programme de Hilbert est irréalisable dans son intégralité

: les fameux théorèmes d'incomplétude démontrent

que, dans n'importe quel système, aussi formalisé qu'il soit,

il existe toujours au moins un énoncé indécidable : tout

système a besoin de chercher des références à l'extérieur

de lui-même, le formalisme intégral est donc inaccessible.

Celui qui incarne le mieux, dans sa vie et dans ses oeuvres, les dilemmes de

cette époque, est dans doute Ludwig Wittgenstein. Inventeur des tables

de vérité, il écrivit au cours de la guerre 1914-1918 son

fameux "Tractatus logico-philosophicus", qui rejette comme faux problème

tout ce qu'on ne peut pas décider formellement. : "Tout ce qui

peut être dit peut être dit clairement; et ce dont on ne peut parler,

il faut le taire". Mais plus tard, après avoir délaissé

l'Université, enseigné plusieurs années comme instituteur,

pratiqué des activités diverses dont de longues retraites solitaires,

il revint à la philosophie, enseignant des théories qui réhabilitent

le langage ordinaire. Il recommande de chercher dans le langage lui-même

les solutions aux questions sur le langage, même s'il s'avère apparemment

incompatible avec les exigences de la logique. Dans on petit opuscule posthume

intitulé "De la certitude" (13), il montre comment

des certitudes acquises au cours de l'expérience quotidienne, éclairée

par les interactions linguistiques en langue naturelle, gisent au font de toute

démonstration scientifique.

C'est dans cette perspective de recherches que naît l'informatique, "une

manifestation de la logique", dit Daniel Andler (6). Les ordinateurs,

issus des recherches des mathématiciens et logiciens, ne peuvent traiter

que des écritures, comme répète Didier Vaudène (14),

écritures dont la référence au monde est comme mise entre

parenthèses ou passée sous silence.

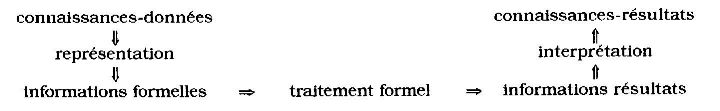

Jacques Arsac (15) a théorisé cette hypothèse pour l'informatique,

qui n'est une science, selon lui, que si on distingue la forme et le sens d'une

connaissance, l'informatique ne traitant que la forme à l'exclusion du

sens. Il propose donc ce schéma, dont l'intérêt est de bien

circonscrire le domaine de l'informatique :

Il conviendrait cependant d'ajouter à ce schéma le "réel"

(ou réalité), inféré mais non connu, car nos connaissances

ne sont qu'une représentation de la réalité. La formalisation

est en quelque sorte un deuxième niveau de représentation qui

consiste à cire nos connaissances sous une forme qui se prête à

la manipulation réglée de symboles, à l'exclusion de toute

interprétation.

Les chercheurs en Intelligence artificielle cependant, butent sur cette limitation

car les activités intelligentes qu'ils tentent de simuler se laissent

difficilement dissocier en traitements formels et référence au

monde : la plupart des opérations intellectuelles s'orientent et se simplifient

en se référant aux objectifs hiérarchisés, aux constants

du bon sens, etc. "Le traitement de l'information, tel qu'il est mis

en oeuvre en informatique, ne retient qu'une toute petite partie des sens que

ces mots ont dans le langage courant", dit Monique Linard (16).

Les recherches les plus avancées en informatique nous conduisent donc

à des questions analogues à celles de Wittgenstein : inéluctablement,

il faudra considérer le fondement du langage ordinaire pour rationaliser

les raisonnements au lieu de se satisfaire d'en étudier les seuls aspects

formalisables. Dans cette démarche exigeante, l'ordinateur nous offre

à la fois le motif pour nous livrer à des recherches ardues et

complexes (pour profiter de toute sa puissance, il faut en passer par là),

et un moyen de valider la rigueur des opérations programmées (ne

dit-on pas que l'ordinateur est un censeur impitoyables de toutes les ambiguïtés

et inexactitudes ?). Après avoir subi, et sans doute mérité,

les reproches de simplification outrancière, de morcellement de la réalité

et de rigidité, l'informatique nous incite à restituer, d'une

façon ou d'une autre, la globalité des démarches intellectuelles;

sa,s éluder les médiations linguistiques et sociales qui les sous-tendent.

Calculant, l'ordinateur sert à organiser le monde

Les premières machines à calculer sont nées au 17eme siècle

avec Schickard (1623), Pascal (1642) et Leibniz(1673). "Seuls les esprits

hors du commun, remarque Jean Marguin (17), pouvaient s'affranchir de la distinction

entre les "arts libéraux" qui restaient le domaine des spéculations

théoriques et des "arts méchaniques" où le clerc

ne devait pas se salir les mains".

Cette distinction doit encore nous aveugler, car Pierre Lévy (17) remarque

qu'on omet souvent d'associer les noms des physiciens à ceux des mathématiciens

comme inventeurs de l'ordinateur. Si Babbage (1837) est justement célèbre

pour avoir rassemblé plusieurs idées qui seront à la base

de l'ordinateur (le programme préétabli sou forme de carton perforé,

le choix entre deux procédures en fonction du résultat d'un calcul

et la réduction des calculs à un ensemble d'opérations

élémentaires), il n'a jamais pu réaliser ses machines,

la technologie restant trop sommaire ; il se fâcha d'ailleurs avec son

mécanicien. Même si le concept de calculateur universel n'est théoriquement

pas astreint à l'électronique, il fallut cependant attendre la

conjonction de la théorie booléenne de la numération binaire

et de l'électronique pour qu'on parvînt à construire des

machines qui servent et qui prolifèrent.

Il convient donc d'insister avec Jérôme Ramunni (19) sur le fait

qu'un ordinateur n'et pas une machine mathématique abstraite, mais une

machine physique, donc soumise aux limitations spatio-temporelles. L'informatique

est d'abord, comme le plaît à le rappeler Paul Namian (20), une

science applique, que le philosophe Ali Klic (21) propose de dissocier, considérant

que l'informatique est un terme générique qui regroupe en réalité

plusieurs disciplines scientifiques et techniques. Ce débat sur la définition

de l'informatique comme science n'est pas tranché. A J. Arsac qui fonde

la science informatique sur le traitement d'une information formalisée,

débarrassée de toute signification (15), Jean-Louis Le Moigne

oppose une autre définition des sciences nouvelles, selon lui fondées

sur un projet et non sur un objet (22). D'ailleurs Pierre Mounier-Kuhn relève

les hésitations du CNRS à trouver la place de l'informatique (23)

tandis que Eric Batard pense qu'on ne peut pas comprendre l'informatique sans

faire appel au concept d'utilisation (24). C'est à son opérationalité

et à son universalité que l'informatique doit son importance économique

et sociale.

Alors, à quoi sert un ordinateur ? Selon les époques, dit Pierre

Lévy (18), cette machine a eu plusieurs images : d'abord calculateur,

puis ordinateur, avant de devenir, en liaison avec les télécommunications,

communicateur.

Le calcul est une très ancienne tradition. Il semble

qu'il soit antérieur à l'écriture, les premiers textes

retrouvés servaient probablement à garder mémoire des comptes,

dans des sociétés au pouvoir centralisé. Dans sa magistrale

histoire des chiffres, Georges Iffrah (25) montre comment les besoins de l'administration

sont stimulé les inventions du calcul. "Le pouvoir est au bout

des nombres" titre Jean-Pierre François (26). "Collecter

les impôts, lever les armées, contrôler les populations"

sont des objectifs qui ont sous-tendu le développement des statistiques

dès le début de l'ère industrielle. D'ailleurs, la première

machine électro-mécanique don l'emploi servira de référence

(le recensement des USA de 1890) sera commercialisée par une firme créée

par Hollerith et qui deviendra IBM en 1924.

Les avis divergent sur les raisons du développement des calculateurs

électroniques. Est-ce la découverte d'une technique adaptée

qui a permis enfin de répondre à des besoins de calcul préexistants

? Ou bien, l'absence de besoins a-t-elle ralenti ou freiné une offre

technique virtuelle, comme le prétend Marguin (17) ? On peut aussi penser

que les premières machines ont répondu à un besoin important

: comme le souligne J-P. François (26), jusqu'au milieu du 20eme siècle,

le traitement manuel a soutenu la comparaison avec les machines. A notre époque

en revanche, la formidable offre de calcul déborde la demande et se révèle

une incitation permanente à résoudre par le calcul des problèmes

qui, auparavant, relevaient des relations sociales, ou de la culture, ou de

l'art.

Les inventeurs universitaires des premiers calculateurs ont profité

de la guerre pour accélérer le développement incertain

de leurs créations, en suscitant la confiance d'hommes politiques en

des techniques qui n'avaient pas encore fait la preuve de leur fiabilité.

Ce faisant, ils ont misé sur l'avantage décisif que pouvaient

donner à leur pays des machines capable de décrypter les codes

ennemis comme l'Eniac (26). A notre époque, malgré quelques voix

discordantes, l'ordinateur reste perçu comme une arme incontournable

de la guerre économique. L'analyse des publicités montre que l'image

la plus fréquente de l'ordinateur est celle d'une arme, image qu'on s'efforce

de plus en plus de dissimule derrière des clichés de nature (arbre,

animaux sympathiques ou pacifiques...) ou de convivialité. Mais l'idée

de puissance réapparaît à la première occasion.

Après la fin de la guerre, les calculateurs se trouvent en panne de

diffusion jusqu'à ce que la représentation "décimale

codée binaire" donne l'opportunité de les utiliser pour des

applications autres que l calcul. La gestion en deviendra le principal débouché.

C'est à cette époque (1956) que les Français inventent

le mot "ordinateur", reprenant un vieux mot français, signifiant

celui qui règle, qui met en ordre, qui organise les cérémonies,

puis le concept d'informatique (1962) qui renvoie à la notion de traitement

rationnel de l'information.

L'ordinateur intervient alors dans l'organisation de la société,

pour y introduire de la rationalité et de l'ordre. On ne peut s'empêche

d'y voir une résurgence de ambitions du Père Dominique Dubarle

(27) à propos des machines à gouverner. Certes, on n'a jamais

vu de machine à gouverner, et les informaticiens, réalistes et

opérationnels, peuvent se gausser des utopistes cybernéticiens.

Pourtant, l'informatique est une aide précieuse pour les gouvernants.

A l'époque des gros systèmes de gestion centralisés, les

informaticiens furent souvent accusés de vouloir imposer, à travers

l'automatisation des procédures administratives, puis des processus de

décision, une rationalité logico-mathématique pas toujours

adaptée aux réalités économiques et sociales. C'est

en particulier l'analyse de Claire Lobet (28) e de Francis Pavé (29),

attentifs aux dysfonctionnements des systèmes de gestion informatisés.

S'il est évident que l'informatique évolue et que la flexibilité

des petits systèmes remédie à beaucoup des inconvénients

des gros systèmes centralisés, il n'est pas sûr que la volonté

de rationalisation ne s'impose pas encore, non de la part des informaticiens,

mais plus largement de ceux qu'il est convenu de nomme technocrates et qui incarnent

l'idéal de notre société, celui de la Raison, issue de

la philosophie des Lumières.

L'ordinateur devant être programmé, n'agit pas tellement dans

l'ordre du "faire" que dans celui du "faire-faire". De tout

temps, celui qui a su expliquer ce qu'il fallait faire a dominé celui

qui faisait. Il convient de prendre la mesure de cette observation, non pour

dénoncer un "pouvoir démoniaque" qu'assiste l'informatique,

mais pour comprendre à quel point elle sert le projet rationalisant de

l'ère industrielle. Pour faire-faire, l'objectivation est incontournable.

Il faut clarifier et expliciter les options, et le décalage dans le temps

qu'implique la programmation informatique conduit à fixer les choix avant

qu'ils ne soient confrontés à la réalité. L'analyse

que nous a proposée Evelyne Volpe à propos des bases de données

urbanistiques (30) montrait que le découpage de l'espace, qui paraît

a priori très simple, s'avère en contraignant, mettant en lumière

certains phénomènes et en occultant d'autres, si bien que les

urbanistes on dû renoncer à un système d'information universel

au profit de sous-ensembles conçus en fonction des finalités restreintes.

Nombreuses furent nos réflexions concluant sur l'utopie d'une rationalisation

radicale aux prétentions objectivantes et organisatrices.

La plus récente image de l'ordinateur comme machine à

communiquer semble mettre en cause ces ambitions souvent considérées

comme dépassées. Certains opposent à cette visée

rationalisatrice une nouvelle société de l'information ou de la

communication, conviviale et universelle. Cependant, on peut s'inquiéter

de la dérive d'une notion de communication qui signifie de moins en moins

un échange au sein d'une relation entre des individus pour se présenter

comme technique.

Jürgen Habermas (31) réagit à cet égard dans sa théorie

de l'agir communicationnel. Reprenant l'analyse de la théorie critique

de l'Ecole de Francfort, il déplore que la rationalité instrumentale,

adaptée à l' "agir téléologique" (ensemble

des activités visant un objectif défini), a envahi toutes les

activités humaines : la recherche de l'efficacité dans la réalisation

d'objectifs a pris le pas sur le choix des finalités et de buts, choix

qui requiert du jugement. Or les décisions politiques, qui orientent

l'action collective, doivent être élaborées à travers

l'argumentation. L'ensemble des activités qui y contribuent, que Habermas

nomme "agir communicationnel", ne relèvent pas de la rationalité

instrumentale, car il ne s'agit pas d'atteindre un objectif prédéfini

par l'un des acteurs, mais de parvenir à un accord le plus harmonieux

possible. Y appliquer une rationalité instrumentale, dans le but de faire

triompher leur point de vue, sans pour autant se donner la peine de faire valoir

de meilleurs arguments, introduit la manipulation dans un domaine où

devrait dominer la négociation. Cependant, il n'est pas simple, voire

impossible, de construire une logique universelle de l'argumentation, car les

significations sont élaborées culturellement, par des collectivités

parlantes, dont les valeurs et modes d'argumentation sont parfois inconciliables.

Peut-on faire triompher l'idée d'un fondement commun minimum ? Pour Habermas,

c'est peut-être utopique, mais il n'y a pas de solution hors de cette

recherche.

* * *

Ainsi, la filiation multiple de l'informatique en fait une discipline carrefour,

qui pose à la société, et à la science en particulier,

des questions complexes et vitales. L'informatique renouvelle l'approche de

l'étude de la cognition, elle pose de façon cruciale la question

du raisonnement et du langage qui est au centre de toute démarche scientifique.

Enfin, par ses multiples applications dans les activités sociales de

gouvernement et de communication, elle nous interroge sur les relations entre

la connaissance et l'action, et sur les différents modes d'action.

Or il me semble que se dégage des trois problématiques liées

aux trois traditions où s'origine l'informatique, une même question.

Si les automates ne parviennent pas à imiter les aptitude humaines accessibles

aux moins doués d'entre les hommes alors qu'ils résolvent mieux

que quiconque certains problèmes sophistiqués, c'est que le formalisme

sur lequel ils se fondent n'est pas le socle sur lequel le cerveau bâtit

son savoir et son savoir-faire. Si le fondement de la logique requiert in fine

la sollicitation du langage ordinaire et de l'expérience de la vie quotidienne

en société pour construire les démonstrations, c'est que

le formalisme n'est pas l'assise de tout raisonnement. Si l'utilisation de l'informatique

au profit de la gestion et de l'organisation du monde, voire de la communicative,

manifeste de multiples dysfoncions, c'est qu'il faut remplacer l'hypothèse

d'une rationalité univoque par celle d'une tension entre des logiques

hétérogènes.

Les fondations de la construction technico-scientifique se révèlent

insuffisantes, et le formalisme est mis en cause dès qu'il se veut intégral.

Si cette mise en parenthèse du sens pour se concentrer sur le traitement

de la forme pure a fait la preuve de son efficacité comme fondement de

la science moderne et dans de nombreuses applications industrielles, elle paraît

bien en bloquer les progrès ultérieurs : ne serait-ce pas une

impasse ? Pour s'en échapper, il faudra sans doute apprendre à

en reconnaître l'intérêt limité et le risque fondamental.

Mais cette exploration de terres nouvelles est particulièrement ardue

car la distinction du sens et de la forme repose sur une base culturelle très

profonde : la séparation de l'âme et du corps, de l'esprit et du

cerveau, de la connaissance et de l'information. Nous sommes tellement habitués

à penser en ces termes qu'il nous est difficile d'en imaginer d'autres.

Pour Antoine Picon (32) l'informatique, en réunissant calcul et logique,

apporte une inflexion culturelle significative. Elle intervient dans un monde

où resurgit la focalisation sur les évènements (ou bifurcations),

après des siècles pendant lesquels la science s'est centrée

sur les régularités. Pour lui, la spécificité de

l'informatique est son aptitude à manipuler les occurrences, à

hiérarchiser les représentations, à gérer des systèmes

de logiques hétérogènes... Ces potentialités incitent

à réinsérer le social dans les processus technologiques.

L'informatique révèle les limites de la science, sans doute parce

qu'elle concrétise idéalement ses visées objectivantes

et opérationnelles. Mais corollairement, on peut penser qu'elle apporte

des moyens pour gérer la complexité engendrée par la prise

en compte d'un réel inaccessible, que nous ne pouvons saisir qu'à

travers des représentations précaires, fondamentalement variables

dans le temps et dans l'espace.

Notes

NB : Les dates situent les interventions des auteurs dans le groupe

"Histoire et épistémologie de l'informatique"

(1) Le groupe de travail a contribué aux définitions du chapitre

"Epistémologie de l'informatique" du "Thesaurus Informatique

et société" que le Creis a réalisé avec

l'aide du ministère de la Francophonie et de l'Afcet. La première

version a été publiée dans le Bulletin de liaison du Creis,

no 109, mai 1992.

(2) L'histoire de la cybernétique est développée dans

les Cahiers du Crea, notamment dans le cahier no 7.

(3) Il convient à ce propos de distinguer :

- le mécanisme, ou combinaison d'organes destiné

à exécuter un mouvement dont il reçoit l'ordre, comme les

machines à écrire ou à coudre ;

- l'automatisme implique que la machine soit capable d'enchaîner

plusieurs opérations sans intervention humaine ; l'enchaînement

est inscrit dans un "programme" tel que le carton des métiers

à tisser Jacquard;

- la régulation est le fait des machines comportant

un mécanisme capable de modifier le programme en fonction des résultats

de son action.

(4) Les oppositions entre les cybernéticiens et les informaticiens ont

été abordées par Philippe Breton le

25 mars 1987 et dans son "Histoire de l'informatique",

Paris, Seuil, 1990.

(5). Imiter : faire comme, de la même façon. Simuler : chercher

à obtenir le même résultat, sans imiter les procédures.

(6). Daniel Andler , 9 avril 1991 : Les sciences cognitives

et aussi "Le cognitivisme en question" Cahiers du Crea, no9,

pp 7-106.

(7). Gérard Verroust, 12 novembre 1989.:Les automates

neuronaux, histoire et perspectives

(8). Henri Atlan : "Entre le cristal et la fumée, essai sur

l'organisation du vivant", Seuil,

Paris, 1979. Les buts assignés à une machine sont inscrits dans

sa structure (ou organisation). L'autonomie serait caractérisée

par la possibilité, pour un organisme, de modifier sa propre structure

(donc ses buts), en intégrant le bruit, autrement dit les données

non prévues dans son fonctionnement normal.

(9). Jacques Pitrat, 14 mars 1994 : L'IA à l'aide de

l'IA

(10). Alain Lecomte , 13 février 1992. "Critique

des représentations du raisonnement à propos de l'analyse des

textes d'histoire" pp. 44-63. cf. aussi "Le marmot et la mamelle",

Actes du colloque Creis, "Représentation du réel et informatisation",

St Etienne, mai 1988.

(11) Bernard Jaulin, 6 avril 1990 : "Quelques aspects du calcul en

logique".

(12) Daniel Lacombe, 11 mai 1989 : Le théorème de Gödel

peut-il aider à penser les limites de l'informatique ? Cf aussi.

"Le problème du fondement depuis Gödel". Les

études philosophiques, oct-déc.? 1969.

(13). Ludwig Wittgentsein "De la certitude". Gallimard,

Paris 1976.

(14). Didier Vaudène :

15 déc. 188 : L'informatique et l'écriture

13 juin 1991 : Tous les traitements d'information sont-ils

réductibles au calculable ?

14 mai 1992 : La question de la représentation

Didier Vaudène a publié une thèse sur les fondements de

l'informatique.

(15) Jacques Arsac. 15 oct. 1992 nous lui avions

demandé de nous présenter le point de ses réflexions sur

la science informatique.

(16). Monique Linard , 6 déc. 1989 : "Quels rapports entre

l'informatique et les Qu'a à voir l'informatique avec les sciences

de la cognition ? " Cf. aussi "Eurytos, ou comment un homme

est-il égal à 666 ?". Actes du colloque Creis, op. cit. (10).

pp. 187-204/

(17). Jean Marguin , sept. 1988. "Les débuts du calcul mécanique

ou la transgression d'un tabou".

(18). Pierre Lévy. 9 fév. 1990 L'invention

de l'ordinateur . Cf. aussi "Temps réel et simulation",

Culture technique, no spécial "L'emprise de l'informatique"

no 21, pp. 246-53.

(19). Jérôme Ramunni :

20 avril 1989 L'histoire de l'ordinateur

10 déc. 1992. La ou les culture(s) informatique(s)

Cf. aussi "La physique du calcul, Histoire de l'ordinateur".

Hachette, Paris 1989.

(20). Paul Namian, 9 février 1989. Le

concept d'information

(21). Ali Kilic : 9 nov. 1990. La place de l'informatique

dans la classification des sciences.

(22). Jean-Louis Le Moigne. 7 février 1991.

"La fondation des sciences nouvelles, en fonction d'un projet et non

pas d'un objet". cf. aussi : "La science informatique va-t-elle

construire sa propre épistémologie ?". Culture technique,

op. cit. (18), pp. 16-31.

(23). Pierre Mounier-Kuhn : 11 avril 1991 . "La

reconnaissance de la science informatique au CNRS".

(24). Eric Batard, 12 nov. 1992 "Prolongements

autour du schéma de J. Arsac".

(25) Georges Ifrah : "Les chiffres ou l'histoire d'une grande ambition".

Laffont, Paris 1985.

(26). "La saga de l'informatique", Science et avenir, no

spécial, no 49.

(27). Dominique Dubarle : "Une nouvelle science, la cybernétique.

Vers la machine à gouverner ? ". Le Monde 28 déc. 1948.

(28). Claire Lobet-Maris : 10 oct. 1991à propos

du colloque "Evolution sociale des nouvelles technologies de l'information

et de la communication". Namur, nov-déc 1990.

Cf aussi Journal de réflexion sur l'informatique no 18, FUNDP, Namur

1991.

(29). Francis Pavé, 14 nov 1991 à propos

de son livre "L'illusion informaticienne", L'Harmattan, Paris

1989.

(30). Evelyne Volpe, 9 janvier 1991 : Représentation

informatisée et espaces habités.

(31) Jürgen Habermas : "Théorie de l'agir communicationnel".

Fayard, Pris, 1987 (2 tomes).

(32). Antoine Picon, 11 mars 1993. . Logique de l'évènement

et paradigme informatique